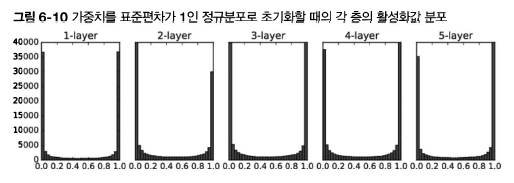

이 포스팅은 밑바닥부터 시작하는 딥러닝을 공부하고 정리한것 입니다. 앞 절에서는 각 층의 활성화값 분포를 관찰해보며, 가중치의 초깃값을 적절히 설정하면 각 층의 활성화값 분포가 적당히 퍼지면서 학습이 원활하게 수행됨을 배웠다. 그렇다면 각 층이 활성화를 적당히 퍼뜨리도록 강제해보면 어떨까? 실은 배치 정규화(Batch Normalization)가 그런 아이디어에서 출발한 방법이다. 1. 배치 정규화 알고리즘 배치 정규화가 주목받는 이유는 다음과 같다. 1. 학습을 빨리 진행할 수 있다 2. 초깃값에 크게 의존하지 않는다 3. 오버피팅을 억제한다 배치 정규화의 기본 아이디어는 앞에서 말했듯이 각 층에서의 활성화값이 적당히 분포되도록 조정하는 것이다. 그래서 다음 그림과 같이 데이터 분포를 정규화하는 '배치..